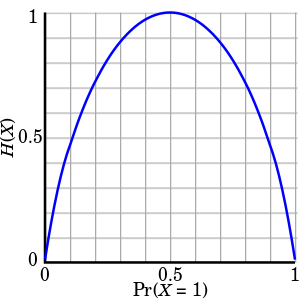

Binary entropy plot

en:Information entropy of a en:Bernoulli trial X. If X can assume values 0 and 1, entropy of X is defined as H(X) = -Pr(X=0) log2 Pr(X=0) - Pr(X=1) log2 Pr(X=1). It has value if Pr(X=0)=1 or Pr(X=1)=1. The entropy reaches maximum when Pr(X=0)=Pr(X=1)=1/2 (the value of entropy is then 1). The image was created in the following steps. First I have created a DVI version starting from a LaTeX/Pstricks source. Here is the code:

%Plot of information entropy of Bernoulli variable

%

%latex binary_entropy_plot; dvips binary_entropy_plot

%open .ps file in gimp, choose strong antialias in both text and graphics,

%resulution 500, color mode, crop, scale to 45%, save as .png

\documentclass[12pt]{article}

\usepackage{pst-plot}

\begin{document}

\psset{unit=4cm}

\begin{pspicture}(0,0)(1.01,1)

\psgrid[gridlabels=0pt,gridcolor=lightgray,subgriddiv=10,subgridcolor=lightgray](0,0)(0,0)(1,1)

\newrgbcolor{myblue}{0 0 0.7}

\psaxes[arrows=->,arrowsize=2pt 4,Dx=0.5,Dy=0.5](0,0)(0,0)(1.1,1.1)

\psplot[plotstyle=curve,plotpoints=100,linewidth=1.8pt,linecolor=myblue]{0.0001}{0.9999}{-1 x x log 2 log div mul 1 x sub 1 x sub log 2 log div mul add mul}

\rput(0.5,-0.22){$\Pr(X=1)$}

\rput{90}(-0.28,0.5){$H(X)$}

\end{pspicture}

\end{document}

Relevantní obrázky

Relevantní články

Informační entropieInformační nebo též shannonovská entropie je střední hodnota množství informace připadající na jeden symbol generovaný stochastickým zdrojem dat. .. pokračovat ve čtení